Archives de la catégorie 'Informatique'

Le Ubuntu nouveau est arrivé !!!

Ubuntu Lucid Lynx 10.04 LTS que nous attendions est sortie à la date prévue. Je ne reviendrais pas sur mes précédents commentaires car la version beta était assez proche de celle finale. D’après mes premiers tests le résultat est assez satisfaisant. L’ensemble est plutôt stable et la migration se fait sans accros. Seuls les développeurs de la version lunbuntu n’en sont qu’à la version beta3 [edit]version finale depuis le 03/05/10[/edit], mais cela s’explique par le projet encore jeune de porter l’environnement LXDE sur une distribution ubuntu.

Voici quelques liens qui vous permettront de télécharger les images ISO des différentes versions de lucid (LiveCD i386):

- – Pour tout autre option voir ici (séléctionneur d’image ISO). Ou encore le mirroir FTP principal des distributions Ubuntu.

Une fois l’image ISO téléchargée, gravez là sur un CD (ou un DVD pour Ubuntu Studio et Edubuntu). Démarrer le LiveCD sur votre PC en bootant dessus au démarrage. C’est pas plus compliqué !!!

Même si les mirroirs et les dépôts sont de plus en plus performants et capables de gérer un nombre important de téléchargement, je vous invite tout de même à utiliser les liens torrent. Ainsi vous aurez un débit plus rapide et vous participerez au partage des ressources des logiciels libres.

NB: Le téléchargement d’une distribution linux est 100% légal, la copie et la diffusion sont même fortement encouragées sous le couvert des licences libres comme la GPLv3 ou BSD open source.

Mithrandir79

Les commentaires sont désactivés pour ce billetPlusieurs LiveUSB Linux bootable sur une seule clef USB

Le LiveUSB est issu de la technologie LiveCD permettant de lancer un système d’exploitation Linux ou certains BSD à partir d’un CD ou d’une clef USB sans s’installer sur le disque dur. Le but étant de créer une partition virtuel dans la Ram (d’où le besoin d’au moins 1Go de ram pour que cela fonctionne correctement). Les logiciels permettant cette exploit sont entre autres syslinux, casper et ubiquity. Hors le système de démarrage de syslinux contenu dans les images LiveCD est monoboot et ne permet pas d’installer plusieurs LiveCD ou LiveUSB sur le même support. Donc quand on utilise une clef USB de 16Go seul 700Mo sont utilisés, c’est du vrai gaspillage.

La solution je l’ai trouvé sur ce site après avoir consulté ce forum. Le logiciel multiboot proposé ici nécessite de l’installer sur un système Ubuntu (mais cela peut sans doute fonctionné).

Le principe est d’utiliser Grub comme bootloader sur la clef USB tout utilisant « fuseiso » pour lire les fichiers ISO. Et un script automatise l’ajout d’image ISO sur la clef USB tout en mettant à jours Grub. Avec ce système une clef USB de 16Go peut accueillir jusqu’à 21 images Live CD de 700Mo.

Si ce projet semble très prometteur il est encore quelques imperfection qu’il faut prendre en compte pour éviter toutes déconvenues. Sur ce site il est proposé un script d’installation qui est censé inscrire le dépôt du le logiciel dans le sources.list, puis d’installer le paquet. Mais il fait d’autre chose qu’on ne lui a pas demandé (ex: activation des icônes dans les menus de gnome !!!!).

La deuxième chose étant que le dépôt ajouté n’est pas signé, donc il y a un fort risque d’usurpation pouvant entrainer l’installation de programme malveillant. Ce problème de sécurité est à prendre en compte avant toutes installation de ce dépôt. (ne pas l’utiliser sur une machine de production ou sur un serveur). J’espère que cette situation s’améliorera dans le temps.

Donc je vous propose ici d’installer manuellement le dépot et le logiciel:

- - Ouvrir un terminal Application>Accessoire>Terminal.

- - Editer le sources.list

sudo gedit /etc/apt/sources.list.- - Ajouter à la fin du texte

deb http://liveusb.info/MultiBoot-v3/depot/ ./. Enregistrer et fermer le fichier.- - Mettre à jour apt, taper dans le terminal

sudo apt-get update.- - Ensuite installer le logiciel, taper dans le terminal

sudo apt-get -y multiboot. Cela installe le logiciel plus les paquets dépendants (fuseiso, qemu, grub-pc, parted, xterm etc…)Le logiciel se lance à partir du menu Application>Accessoires>Multi System. Maintenant il suffit juste de télécharger les images LiveCD et de les glisser sur la fenêtre de Multiboot.

NB: Multiboot ne peut démarrer que si une clef usb en fat32 est connecté au PC.

J’ai eu quelques souci avec certains disques durs !(mais normalement ça fonctionne) Cependant j’ai une astuce pour y palier:

- - Installer au moins une image ISO de LiveCD sur une clef USB.

- - Puis copier l’intégralité de la clef USB sur le disque dur externe.

- - Ouvrir un terminal et taper

syslinux /dev/sdb1. « sdb1″ étant un exemple il faut le remplacer par celui de votre disque externe.- - Démarrer « Multi System » votre disque dur sera maintenant reconnu et de nouvelles images pourront être ajoutées.

Maintenant il ne vous reste plus qu’à remplir votre disque dur avec un nombre exhorbitant de liveCD et de colporter la bonne parole du logiciel libre à toutes les install party où vous irez. Vous pourrez ainsi montrer la diversité des environnements disponibles sur linux. A noter que PC-BSD 8 ne fonctionne pas encore sur ce système. Il aussi possible d’ajouter des CD d’installation Windows grâce à « Plop » mais j’avoue ne pas l’avoir essayer.

Mithrandir79

Les commentaires sont désactivés pour ce billetRemettre le « hiddenmenu » dans Grub 2

Grub est un petit programme permettant de pouvoir choisir entre plusieurs système d’exploitation au démarrage (Linux/Windows/BSD etc…). Il a l’avantage par rapport à son ancêtre Lilo d’être très flexible est facilement paramétrable en mode texte. Depuis la sortie d’ubuntu 9.10 une nouvelle version de Grub V1.97 beta (pré-version 2) a été inaugurée. Le paramétrage a été complètement revu et automatisé. Le fichier de paramétrage de grub /boot/grub/grub.cfg est donc totalement différent de l’ancien menu.lst. Qui plus est lors d’une mise à jour du kernel il sera automatiquement totalement réécrit. Donc si on le modifie manuellement il faudra refaire la modification à chaque mise à jour de kernel.

Dans l’histoire l’option de l’ancien grub « hiddenmenu » a tout bonnement disparu du fichier grub.cfg. Cette option permettait de cacher le menu de sélection au démarrage du système et c’était le boot par défaut qui était lancé, il suffisait d’appuyer sur « Echap » lors de la séquence de boot pour voir apparaître le menu. C’est un procédé bien pratique quand on a un ordinateur familial où on a installer discrètement et égoïstement sur un coin de partition un petit linux et qu’on veux pas trop que ça se sache…

Avec Ubuntu Karmic j’avais bidouillé un truc pour pouvoir rester à la version 1 de grub, en installant d’abord Ubuntu Jaunty puis en l’upgradant d’une version. (Karmic ne fait pas la mise à jour automatiquement de grub 1 à grub 2). Mais voilà, dans à peine 10 jour Lucid Lynx va pointer le bout de son nez et je me vois mal faire 2 upgrades successivement juste pour garder mon « hiddenmenu » si tant est que lucid ne fasse pas la mise jour vers grub 2 automatiquement.

C’est par inadvertance, au détour d’un bois de topic, que je suis tombé sur un buisson ardent me donnant par la même occasion la bonne parole et surtout LA solution.

Parce que je ne suis pas méchant et que ça mérite une petite pierre de rosette, je vais m’atteler à une libre traduction juste pour vous :

- - Ouvrir un terminal,

- - Faites une sauvegarde du fichier « /etc/default/grub » en tapant la commande

sudo cp /etc/default/grub /etc/default/grub.bkup1.- - Editer le fichier en faisant

sudo gedit /etc/default/grub.- - Décommenter la ligne 5 (supprimer le « # » en début de ligne) contenant ce texte «

#GRUB_HIDDEN_TIMEOUT=0 » et remplacer la valeur »0 » par le temps d’attente en seconde (cela laisse le temps d’appuyer sur échap) 5 secondes est une bonne valeur. Enregistrer et fermer gedit.- - Faites une sauvegarde du fichier « /etc/grub.d/30_os-prober » en tapant la commande

sudo cp /etc/grub.d/30_os-prober /etc/grub.d/30_os-prober.bkup1.- - Editer le second fichier en faisant

sudo gedit /etc/grub.d/30_os-prober.- - Commenter (ajouter un « # » en début de ligne) vers les lignes 26 ou 27 contenant «

if [ "x${found_other_os}" = "x" ] ; then et 62 ou 63 contenant le dernier fi avant l’accolade « } ». Enregistrer et fermer gedit.- - Maintenant faites une mise à jour de grub avec

sudo update-grub. Le fichier « /boot/grub/grub.cfg » sera recréer de façon automatique et permanent. A chaque mise à jour du kernel cette modification sera prise en compte.- - Redémarrer l’ordinateur un écran noir de 5 secondes attend que vous appuyiez sur « echap » pour accéder au menu. Si vous n’appuyer pas le démarrage se fera avec le choix par défaut.

Grâce à cette manipulation je vais pouvoir continuer à squatter chez les autres avec mon linux sur leur bout de disque dur en toute discrétion…

Mithrandir79

Les commentaires sont désactivés pour ce billetRéparation de mon portable Packard Bell TN65

Mon PB TN65-M-007 FR m’a lâché sans prévenir il y a de ça une semaine, il ne s’allume plus du tout, et quand je met le cordon d’alimentation (qui lui fonctionne parfaitement bien, je l’ai vérifier avec un multimètre) je sens une légère tension sur la coque quand je passe la main dessus. La carte mère doit certainement faire masse quelque part au niveau de la gestion de l’alimentation.

J’ai démontée entièrement le PC pour analyser la carte mère et je n’ai pas trouvé de composant cramé, tout semble correcte visuellement. J’ai testé tous les composants séparément et tout fonctionne (processeur, ram, HDD, lecteur CD, carte wifi, bluetooth…) il n’y a que la carte mère qui semble être défectueuse.

Si ce problème est dû à une soudure sèche la solution serait de repasser au fer à souder les soudures qui paraissent suspectes. Mais cela est fastidieux, et les composants sont extrêmement petits (moins d’1 mm).

Je suis aller sur youtube pour y voir différentes techniques de réparation, four, décapeur thermique, poste à dessouder à air pulser, fer à souder classique et même une bougie au white spirit.

Je dois dire que le four et la bougie me paraissent un peu sauvage et conviennent mieux à une carte graphique qu’à une carte mère entière. La technique du poste à dessouder à air pulser me paraît la plus précise et la plus efficace, mais le prix du matériel est exorbitant (parfois plus cher qu’un PC portable neuf). Je vais donc opter pour le décapeur en ciblant les zone du connecteur de l’alimentation et du connecteur de la batterie. J’ai passé commande pour un décapeur Black & Decker d’occaston, j’attends de le recevoir et je vous communiquerai le résultat.

Le principe étant de faire redevenir liquide l’étain pendant un instant, sans trop chauffer les composants. Cette technique est surtout utilisée pour réparer les soudures des puces de cartes graphiques, mais il n’y a pas de raison que cela ne fonctionne pas pour des composants moins complexes. La précaution à prendre est de recouvrir de papier aluminium les zones sensibles de la cartes pour éviter de faire fondre le plastique. Je ferai une petite vidéo de la manipulation pour expliquer mon approche.

Je tiens aussi à dire c’est que c’est la dernière fois que j’achèterai un Packard Bell, l’apparence et les performances sont assez bons dans l’ensemble, mais la fiabilité est franchement à revoir. Comment un PC portable peut-il avoir une carte mère HS en à peine 2 ans pour une utilisation occasionnelle?! Mon second portable Asus F3M qui a plus de 3 ans que je ne ménage pas, tourne 20/24H et n’a pour l’instant montrer aucun signe de faiblesse.

Qui plus est, Packard Bell a une façon bizarre d’assembler ses PC portable, le TN65 a sa carte mère la tête en bas sans ouverture au dos du PC pour la maintenance de routine (nettoyage des ventilateurs et radiateurs, changement de la pile CR2032 etc…), ce qui oblige à tout démonter entièrement. (ce que je n’ai pas fait pendant 2 ans afin de garder la garantie). 2 ans et un mois après l’avoir acheté, VLAN!!! carte mère HS, je me demande si ce n’est pas programmé par le constructeur.

Et enfin cerise sur le gâteau, contrairement à IBM ou Dell, Packard Bell ne fournit pas de pièces détachées donc le seul moyen est de rechercher des pièces d’occasions ou des PC HS pour trouver les pièces.

Donc si vous devez acheter un PC portable, Packard Bell est à éviter absolument. Le top du top pour les services après vente c’est quand même IBM avec ses thinkpad, et dans une moindre mesure Dell, il est possible en négociant un petit peu de se procurer une grande partie des pièces de rechange.

Voili je vous tiendrai au courant de ma réussite (je croise les doigts).

[edit:]Bon… je viens de faire un essai avec le décapeur thermique, et ça n’a pas vraiment fonctionné. Je vais peut-être essayer de mettre la carte mère dans le four 9 minutes thermostat 220°C (la température de fusion de l’étain est de 210°C). Perdu pour perdu autant essayer.[/edit]

Mithrandir79

13 commentairesDémarrer et éteindre un PC à distance

Il s’agit ici d’exploiter une fonction « wake on lan » disponible sur la plus grande partie des cartes mères de PC. Le principe est envoyer un paquet « magique » via un port ethernet qui réveillera le PC. Cette méthode demande de petite connaissance en ligne de commande, mais rien d’insurmontable même pour un débutant.

NB: Je vois déjà poindre la question « est-ce que c’est possible de faire la même chose avec une carte WiFi ? » Eh bien la réponse et non si vous utilisez une clef ou un dongle USB WiFi, et je ne pense pas avec les carte PCI, PCI-express, PCMCIA et card-express WiFi. Car il faut que la carte reste à l’écoute du paquet « magique » et à ma connaissance les cartes WiFi sont inactives lorsque le PC est éteint.

Les pré-requis :

- - Posséder une carte mère et une carte réseau compatible Wake On Lan (WoL). Quasiment toutes les cartes conçues après 1996 sont compatibles. Cependant les cartes mères ayant une version de slot PCI inférieure à 2.2 doivent utiliser un connecteur « Wakeup-link » pour être raccordées à une carte réseau.

- - Il faut relever les adresses MAC des cartes réseaux des PC à réveiller.

- - Avoir les droits administrateur pour les systèmes linux.

- - Avoir un réseau local bien protégé contre les intrusions extérieures. Sinon vous risquez d’avoir des démarrages intempestifs dû à des bots malveillants.

Activer la fonction wake on lan dans le bios :

/!\ Toutes manipulations dans le bios présente un risque, ne touchez seulement que les réglages dont vous êtes sûr.

Cette fonction peut porter plusieurs nom selon les bios et les marques de cartes mères. La plupart du temps la fonction WoL se trouve dans la partie gestion d’énergie « Power Management ». On peut trouver les dénominations « WoL » « Wake on Lan » « Wake on PCI » etc… Réferrez-vous à la documentation de votre carte mère.

Certain PC portable, notamment ceux de la marque Acer, offre un Bios plutôt succinct ne proposant pas de débloquer cette fonction. Essayer de passer à la dernière version du bios on ne sait jamais. Sinon votre aventure s’arrête ici.

Définir un login automatique pour Ubuntu et conseil pour Windows XP :

Le but étant de chaîner le démarrage pour arriver sur le bureau de l’utilisateur. Cela peut servir s’il on désir accéder à l’ordinateur distant avec VNC par exemple. Si le démarrage reste bloqué sur le login ou GDM, VNC ne pourra pas se lancer correctement.

- - Ubuntu : L’idéal est de créer une session invité avec le minimum de droit possible. Pour cela aller dans Système>Administration>Utilisateurs et Groupes, authentifiez vous en tant que root, ajouter un utilisateur créer le compte invité et décocher les options de l’onglet Privilèges utilisateur. Le mot de passe root vous sera demandé pour toutes ces opérations décocher. Ensuite pour chaîner le démarrage aller dans Système>Administration>Fenêtre de connexion, authentifiez vous en tant que root, cocher Se connecter automatiquement en tant que choisir le compte invité et enfin cochez la case Attendre pour permettre à un utilisateur de se connecter avant le compte invité.

- - Windows XP : Par défaut Windows XP (Eh oui je n’ai pas de licence pour vista et Seven mais le principe reste le même) se connecte automatiquement s’il n’y a qu’un seul compte utilisateur. Qui plus est ce compte est toujours un compte administrateur, les risques sont très grand si une personne tente de s’introduire sur ce PC. Donc il est indispensable de créer un compte invité sans mot de passe et d’imposer un mot de passe au compte administrateur. Ensuite on utilisera TweakUI pour chaîner la connexion sur le compte invité (n’ayant pas de système windows XP sous la main je ne peux pas être plus précis).

Empêcher à l’extinction du PC que la carte réseau ne soit désactivée :

A ma connaissance les windows XP, Vista et Seven ne désactivent pas les cartes réseaux lorsque le PC est éteint. On peut le vérifier simplement en regardant si les led de la carte réseau restent allumé lorsque le PC est éteint.

Sur Ubuntu Hardy, Intrepid, Jaunty et Karmic (je n’ai pas essayé cette fonction sur les versions antérieures à Hardy) les cartes sont désactivées par défaut pour une raison de sécurité semble-t-il. Il faut donc la réactiver à chaque redémarrage. La solution est simple et la voici. Taper dans un terminal :

sudo ifconfigRepérer le nom « ethx » (la plupart du temps eth0) de la connexion réseau active (celle qui possède une adresse IP). Vous pouvez zn même temps relever son adresse Mac son la forme FF:FF:FF:FF:FF:FF . (chaque carte réseau a sa propre adresse MAC)

sudo ethtool eth0« eth0″ étant un exemple. Repérer la ligne « Wake-on: d » qui signifie que le WoL est désactivé.

Activer le WoL en tapant :

sudo ethtool -s eth0 wol gsudo ethtool eth0La ligne sera passer à « Wake-on: g » ce qui indique que le WoL est activé sur la carte réseau.

Une fois que ceci est vérifié il faut qu’à chaque redémarrage du PC que la carte réseau soit réactivée. Il faut éditer le fichier « rc.local » cela taper dans un terminal :

sudo gedit /etc/rc.localPour faire simple ce fichier lance des lignes de commande au démarrage du système. La ligne de code suivante devra être placée juste avant la ligne « exit 0 » :

ethtool -s eth0 wol gEnregistrer et fermer Gedit. Cette ligne n’a pas besoin de « sudo » puisque ce fichier est exécuté en root.

Voilà votre PC sera à l’écoute du paquet « magique » qui le réveillera. Maintenant passons au PC qui pourra réveiller le dormeur.

Envoyer un paquet « magique » vers un PC endormi :

Le terme paquet « magique » est celui employé dans la documentation concernant le WoL. Bien que je n’aime pas ce terme (car il n’y a rien de magique en informatique) je l’utilise quand même pour me conformer au jargon.

Sur ubuntu il existe dans les dépôts un logiciel permettant d’envoyer le paquet « magique » grâce à l’adresse MAC du PC endormi. Pour l’installer taper dans un terminal :

sudo apt-get -y install wakeonlanPour envoyer le paquet « magique » taper dans un terminal :

wakeonlan FF:FF:FF:FF:FF:FFSi tout se passe bien votre PC endormi doit se réveiller.

Note: Sur la dizaine de PC où j’utilise le WoL, une seule carte mère m’a posée des problèmes. C’est une Asus A8N5X avec un chipset nForce4 où la commande pour activer le réveil est assez particulière. Si l’adresse MAC du réseau est comme suit 00:AB:34:FE:67:CD par exemple il s’agira de taper l’inverse de l’adresse dans la ligne de commande ce qui donne « wakeonlan CD:67:FE:34:AB:00″ allez savoir pourquoi!! Apparemment cela ne concerne que les cartes mère avec le chipset nForce4. Plusieurs rapport de bug traîne depuis 3 ou 4 ans à ce sujet chez nVidia, debian et launchpad mais tous restent au point mort.

Sur Windows il existe un logiciel gratuit Wake on Lan assez efficace et simple d’emploi.

Sachez qu’il est possible d’envoyer un paquet magique via internet, mais avec certaines conditions qui peuvent remettre en cause la sécurité de votre réseau. Il faut ouvrir les ports 0, 7 ou 9 (selon les cartes réseau) de votre modem-routeur. Les paquets magiques envoyés doivent être encapsuler en UDP pour passer à travers le NAT du modem-routeur. Le PC endormi doit avoir une adresse IP fixe associé à sont adresse MAC car le réveil doit se faire par l’adresse IP et non par l’adresse MAC. Pour plus de précision voir ici en fin de page (je ne l’ai pas testé).

Comment arrêter un PC distant :

L’utilisation d’un tunnel SSH est une des méthodes les plus simple pour envoyer un « halt » dans un terminal du PC distant. Mais personnellement je préfère utiliser l’excellent Webmin qui dispose d’une grande diversité d’outil d’administration d’un système linux à distance grâce à une interface graphique via un navigateur internet (firefox de préférence). Webmin doit être installé sur le PC distant (à éteindre).

Ajouter le dépôt de webmin dans votre sources.list en tapant dans un terminal pour l’éditer :

sudo gedit /etc/apt/sources.listAjouter à la fin du fichier cette ligne :

deb http://download.webmin.com/download/repository sarge contribC’est un dépôt pour debian mais cela fonction très bien sur ubuntu.

Enregistrer et fermer le fichier. Puis valider la clef gpg du dépôt en tapant dans un terminal :

wget http://www.webmin.com/jcameron-key.ascsudo apt-key add jcameron-key.ascsudo apt-get updatePour installer webmin taper dans un terminal :

sudo apt-get -y install webminWebmin est maintenant installé sur le PC que vous voulez éteindre à distance. Pour utiliser webmin sur le PC directement il suffit de taper dans la barre d’adresse de Firefox :

https://127.0.0.1:10000 ou bien https://localhost:10000Pour une connexion distante on peut taper dans la barre d’adresse de firefox de n’importe quel autre ordinateur du réseau :

https://192.168.1.XXX:10000192.168.1.XXX étant une adresse IP fixe au PC distant. Mais il possible de définir une adresse relative avec le nom du PC (pour les réseaux en DHCP) comme suit :

https://nomdupc.local:10000Le login et le mot de passe sont ceux utilisés par l’utilisateur du poste distant.

Une fois connecté, aller sur Others>Command Shell, puis taper « halt » et enfin appuyer sur le bouton Execute command: le PC distant s’éteindra en quelques secondes. Webmin permet de faire beaucoup plus de chose, mais ce n’est pas ici l’objet de cet article. J’aurai certainement l’occasion d’y revenir dans un autre article et m’attarder plus longuement sur ce logiciel.

Il y a une autre solution un peu plus lourde qui consiste à lancer une connexion sur le bureau à distance. Le paramétrage est assez simple mais il faut un bon débit sur le réseaux pour le transfert de la vidéo du bureau (100Mb/s soit 12Mo/s). L’activation de l’accès au Bureau à distance se fait dans « Système>Préférence>Bureaux à distance » là l’interface est assez explicite. Ensuite pour visionner le Bureau à distance aller dans « Applications>Internet>Visionneur de Bureaux à distance ».

Sur windows il doit certainement avoir un moyen d’éteindre le PC à distance, (VNC, ou en SSH avec Putty) mais j’avoue ne pas avoir creusé la question plus que ça. Cela fait bientôt 6 ans que j’ai abandonné Windows que je connaissais comme le fond de poche à l’époque. Mais aujourd’hui je n’ai plus vraiment la patience de suivre les évolutions des nouveaux opus Vista et encore moins Seven. Donc si vous avez des sotutions pour windows n’hésitez pas, les commentaires sont là pour ça.

Une petite dernière précision, lorsqu’on éteint les PC avec l’interrupteur à l’arrière de l’alimentation ou quand une panne de courant survient, quasiment toutes les cartes mères ne réactivent pas d’elle même la carte réseau lorsque le courant revient. Il est alors nécessaire de démarrer une fois manuellement les PC pour réactiver les cartes réseaux. Une autre solution consisterait à configurer dans le BIOS la position ON après une coupure de courant cela aura pour effet de rallumer tous les ordinateurs quand le courant revient.

Et enfin je finirai par une mise en garde, si vous disposez d’un parc de 30 PC à démarrer en même temps par script, échelonnez les démarrages 2 par 2 avec un interval de 10 secondes. Cela évite un pic élevé de consommation qui serait perçu par l’installation électrique comme un court-circuit et donc le déclenchement du différentiel. (J’en ai eu l’expérience en démarrant mes 5 PC simultanément chez moi ^^; )

Mithrandir79

Les commentaires sont désactivés pour ce billetUbuntu Lucid Lynx 10.04 prend forme

Le jour de la sortie de la prochaine mouture d’Ubuntu Lucid Lynx 10.04 prévu le 29 avril 2010 approche et il très difficile de résister à l’envie de voir ce que nous prépare l’équipe de Mark Shuttleworth. Ayant installé sur une machine virtuelle le Lynx depuis l’alpha 2, je suis régulièrement l’évolution de la bête au rythme des mises à jour hebdomadaires.

Et ces dernières mises à jour de la version alpha 3 laissent enfin entrevoir ce que donnera la version finale de notre futur chat au regard affuté. Pour l’apparence nous avons un nouveau logo, un nouveau splashscreen, un nouveau thème et un nouveau fond d’écran.

Voici quelques spécifications qui se veulent très raisonnable pour une LTS (Long Time Support):

- - Noyau linux 2.6.32 (amélioration des performances, KVM intégrera la téchnologie de déduplication de mémoire KSM qui réduira les doublons lorsque plusieurs machines virtuelles sont en fonctionnement simultanées et enfin on notera quelques améliorations de la gestion d’énergie des périphériques. Pour la liste complète des changements jetez un oeil ici (en)).

- - Gnome 2.30 pour Ubuntu (la version 3.0 n’est pas encore assez stable pour intégrer une LTS, d’ailleurs la version 2.30 sera certainement la dernière de la série 2.x).

- - KDE 4.4 pour Kubuntu (une version qui se veut plus mature que les précédentes moins de bug et plus de fonctionnalité).

- - Intégration de Plymouth pour le splashcreen de démarrage utilisant l’accélération graphique directement à partir du noyau sans passer par X.

- - Intégration avancée du Cloud Computing (interconnexion de tous les ordinateurs d’un réseau pour un partage des ressources de façon optimale).

- - Suppression de The gimp des programmes par défaut au profit de F-spot (The gimp est toujours disponible dans les dépôts je vous rassure).

- - Ajout de Pitivi comme programme de montage vidéo par défaut (très bon programme malgrès encore quelques bugs encore existant).

- - Ajout de Gwibber comme programme de microblogging par défaut (gère entre autres les fonctions de Twitter).

Lucid Lynx annonce donc une version d’ubuntu visant la robustesse plutôt que l’innovation, ce qui est tout à fait normal pour la future LTS. Le relookage déjà amorcé dans Karmic Koala sera peaufiné pour cette version. Fini les tons orange/marron/sable de human, place au design sobre et léger que les utilisateurs attendaient depuis Hardy Heron.

Le calendrier des sorties des betas, RC et de la version finale :

NB: Les distributions Ubuntu estampillées LTS seront supportées par canonical pendant 3 ans pour les versions en station de travail et 5 ans pour les versions serveurs. Toutes autres versions ne sont supportées que 1 ans et 6 mois en sachant qu’une version courante sort tous les six mois et tous les 2 ans pour les LTS. Ce dispositif a été mis en place pour que les entreprises utilisant Ubuntu aient un rythme de mis à jour de 2 ans au lieu des 6 mois pour les particuliers. Les distributions Ubuntu LTS sont sensées être plus robustes que les autres versions intermédiaires, et les mises à jours d’une LTS à une autre est possible. Les précédentes versions LTS sont Dapper Drake 6.06, Hardy Heron 8.04 et la prochaine sera notre Lucid Lynx 10.04.

Mithrandir79

1 commentaireInstallation de PC-BSD 8.0

Avant de commencer, un petit retour en arrière sur l’histoire de BSD est nécéssaire pour comprendre l’intérêt de la distribution PC-BSD par rapport à un système linux.

C’est en 1969 que les premières lignes de code d’UNICS (qui deviendra UNIX par la suite) ont été écrites par des étudiants de l’Université de Berkeley en Californie. Pour faire court ce fut le premier vrai système d’exploitation de l’histoire informatique (le DOS et Windows ne sont apparus que 15 ans plus tard). En 1978, suite a des problèmes de droits entre AT&T et l’université de Berkeley, UNIX fut totalement réécrit pour donner la première version de BSD (Berkeley Software Distribution). BSD avec sa version 4.3 en 1985 devint alors le meilleur système d’exploitation plus performant et portable que l’UNIX original. A l’époque les développeurs de Berkeley ne croyaient pas au développement de l’ordinateur personnel. Le prix d’une licence BSD coutait alors plusieurs millier de dollars et le nombre de copie (sur bande) n’excédait pas la dizaine de millier.

On peut dire que c’est sur cette erreur de stratégie que Micro Soft (à la demande d’IBM) s’est engouffré dans la brèche de l’ordinateur personnel avec son DOS (Dirty Operating Système) racheter pour une poignée de dollar à une petite firme de Seattle. L’histoire de l’informatique aurait pu (ou aurait dû) être différente, mais malheureusement ce n’est pas toujours les meilleures technologies qui le remportent. On voit bien aujourd’hui dans quel état désastreux se trouve l’informatique personnel au niveau de la sécurité (virus, spyware, phishing, gestion des droits etc…). Cela aurait pu être évité si les systèmes d’exploitations de Microsoft avaient été conçus dès le début avec plusieurs niveaux de sécurité. Windows 7 en natif n’a toujours pas de mot de passe obligatoire pour l’administrateur et les partitions NTFS en natif gèrent très mal les droits d’accès aux fichiers.

Depuis 1985 BSD est toujours resté plus ou moins en marge du marché grand public des systèmes d’exploitations. Pourtant certains autres systèmes d’exploitation s’en sont inspiré voire repris la base. (Linux en respectant les normes POSIX et Mac OS en reprenant BSD pour créer son noyau Darwin). Cet arbre généalogique des systèmes UNIX résume assez bien l’évolution des systèmes UNIX jusqu’à maintenant.

Il faut l’avouer jusqu’à aujourd’hui les utilisateurs de BSD ont toujours été des geeks vouant une dévotion envers le seul et unique système d’exploitation digne de ce nom (selon eux). D’ailleurs la communauté de BSD a une assez mauvaise réputation (souvent à tort) pour sa convivialité détestable et son agressivité envers les débutants. Il existe en réalité 3 branches de distribution BSD qui se revendiquent chacune d’être les puristes dans leur domaine. Tout d’abord FreeBSD, utilisée essentiellement pour des serveurs, puis NetBSD qui a la vocation d’être facilement portable sur n’importe quel matériel, et enfin OpenBSD dont le niveau de sécurité très élevé est le principal enjeu (Il est d’ailleurs souvent utilisé par les militaires pour leurs systèmes stratégiques). Cette attitude élitiste n’a vraiment pas aidé à faire sortir de l’ombre BSD au profit de GNU/Linux qui connaît depuis ces dernières années un assez bon succès.

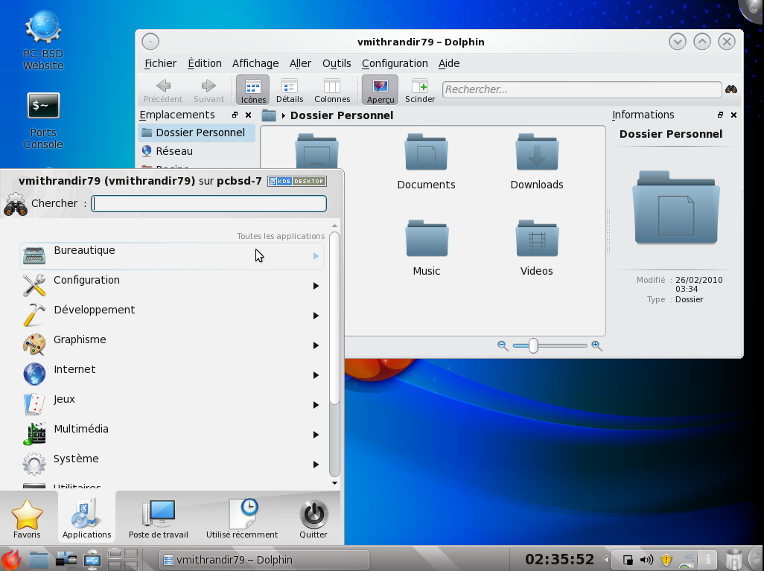

C’est sur ce tableau un peu sombre de l’histoire de BSD, que PC-BSD tente de rendre ce système un peu plus attrayant et plus convivial en offrant une distribution basée sur FreeBSD plus accessible au commun des mortels. En fait on pourrait dire que PC-BSD est à FreeBSD ce Ubuntu est à Debian. L’objectif de cette distribution est d’offrir une installation automatisée de l’interface graphique KDE 4.3.5, ce qui n’est pas vraiment le cas de FreeBSD en natif. Espérons que ce soit la fin du purgatoire de BSD grâce à cette brillante initiative.

Donc je vous propose de faire un petit tour du propriétaire pour vous en faire une idée. A l’instar du manchot de Linux, BSD à pour mascotte un démon rouge avec 2 petites cornes sur la tête et un trident. Cela vient du fait que les systèmes Unix utilisent des daemons (petits programmes d’arrière plan).

Maintenant si je vous ai mis l’eau à la bouche passons à l’installation de PC-BSD 8.0.

Vous pouvez télécharger l’image ISO x86 sur FTP ici, si ce lien est mort allez voir le site officiel. Le lien bittorent est à privilégier si vous n’avez pas un très haut débit de téléchargement.

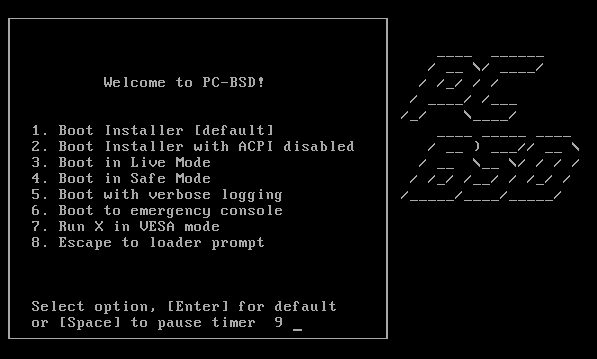

- Graver le DVD et lancer le DVD au boot.

- Choisir l’option « 3 » Live Mode

- Répondre « y » à la question « check integrity of installer archive? » patienter un moment pendant la vérification de l’intégrité des paquets (pour aller plus vite répondre « non » mais c’est déconseillé pour une installation fiable)

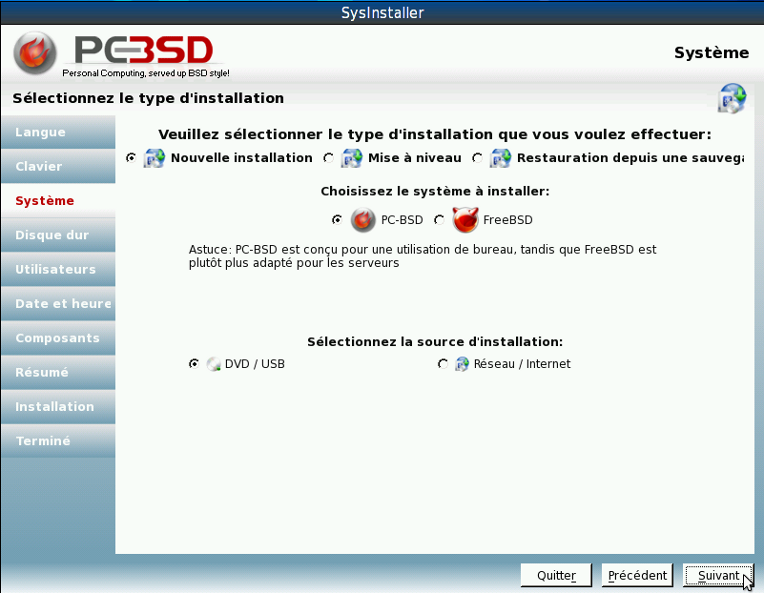

- Choisir la langue, puis suivant.

- Choisir le clavier Français et none, puis suivant.

- Laisser les sélections par défaut pour une nouvelle installation avec interface graphique, puis suivant.

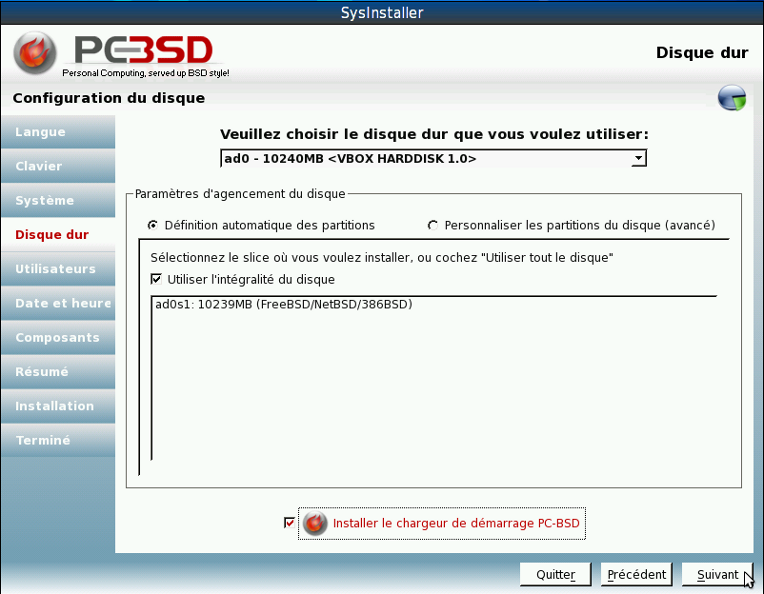

/!\ Si vous testez sur virtualbox vous pouvez utiliser un partitionnement automatique.

- Cocher « Définition automatique des partitions », « utiliser l’intégralité du disque » et « installer le chargeur de démarrage PC-BSD ». Puis suivant.

/!\ Pour une installation en dur le partitionnement automatique est déconseillé à cause du risque de perte de donnée. Donc un partitionnement manuel est fortement conseillé.

- L’idéal est de créer 4 partitions « / », « /var », « /usr » et « swap ». Pour la racine « / » 2Go minimum est nécessaire, pour « /var » un minimum de 8Go est exigé et le « swap » environ 2 fois la Ram avec un maximum de 2Go. Cocher « Installer le chargeur de démarrage PC-BSD » s’il y a plusieurs systèmes d’exploitations installer sur le PC. Puis suivant.

NB: Sur FreeBSD le répertoire /home se trouve dans /usr/home, mais pour garder la compatibilité entre linux et BSD il y a un lien /home qui redirige les programme vers /usr/home. C’est pour cela que le slice /usr est créer à la place de /home pour un système linux. Sur BSD les partitions s’appellent des slices (tranche en français).

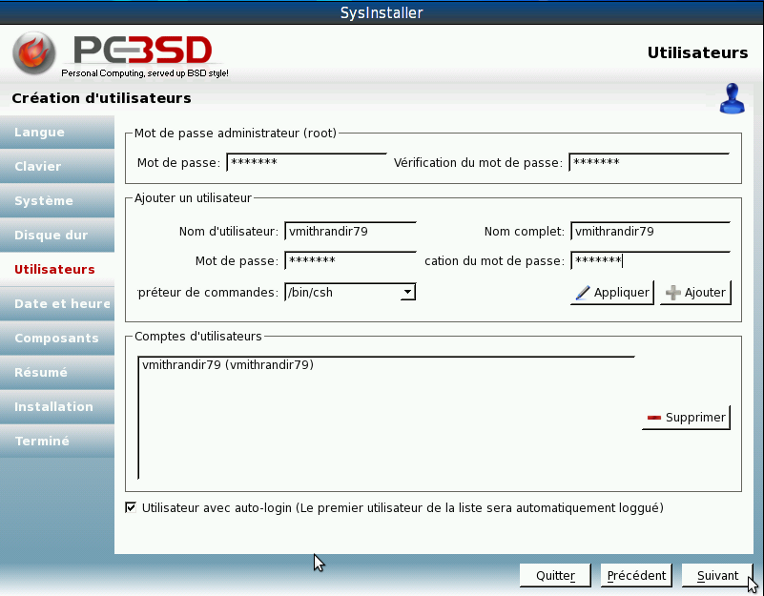

- Entrer le mot de passe root. Créer tous les utilisateurs nécessaire (pour les utilisateurs de « bash » sous linux il est possible de personnaliser l’interpréteur de commande pour chaque utilisateur). Cocher « Utilisateur avec auto-login » si vous voulez passer automatiquement le login de KDM. Puis suivant.

- Choisir le fuseau horaire « Europe/Paris ». Puis suivant.

- Choisir les composants additionnels (Firefox, Opera, VLC, Thunderbird, Pidgin etc…). Puis suivant.

- Vérifier que tout est correcte dans le résumé. Puis suivant.

- Démarrer l’installation « Yes ». L’installation dure environ 45-50 minutes.

- Une fois l’installation terminée, redémarrer.

- Petit aperçu de PC-BSD avec une interface KDE 4.3.5 .

A l’utilisation mon impression est plutôt bonne par rapport aux précédents essais sur FreeBSD. L’installation de l’interface graphique est devenue aussi facile que pour une distribution linux grand public. Le seul petit bémol reste la traduction quasi en français inexistante des logiciels spécifique à BSD. Mais je pense que si cette distribution s’améliore encore pour les prochaines versions, la communauté de traducteur ne fera que grandir. Et enfin le site français www.pcbsd.fr et à votre disposition pour suivre l’évolution de PCBSD dans la langue de Molière. Bref enfin un BSD accessible et convivial, à essayer absolument.

Mithrandir79

Les commentaires sont désactivés pour ce billetInterview de Richard Stallman par 01.net

Voici une interview de Richard Stallman (papa du logiciel libre) par 01.net datant du 29 janvier 2010. Il s’exprime notamment sur la politique liberticide menée par la France ces dernières année en matière loi sur les technologies numériques.

Pour mieux comprendre les arguments de Stallman je rappelle les 4 libertés sur lesquelles s’appuient les logiciel libre sous licence GPL.

Les quatre libertés essentielles de l’utilisateur d’un programme

Liberté 0 : la liberté d’exécuter le programme comme tu veux.

Liberté 1 : la liberté d’étudier le code source et de le changer pour que le programme fasse ce que tu veux.

Liberté 2 : la liberté d’aider les autres, c’est-à-dire la liberté de redistribuer des copies exactes du programme, quand tu veux.

Liberté 3 : la liberté de contribuer à ta communauté, c’est-à-dire la liberté de distribuer des copies de tes versions modifiées du programme, quand tu veux.

Voici le contenu de cet interview :

Fondateur du mouvement GNU, à l’origine du logiciel libre dans les années 1980 et de la première version de la licence GPL en 1989, Richard Stallman était à Paris le 12 janvier dernier pour parler de sa biographie, parue aux Editions Eyrolles (1).

01net. : Votre biographie « autorisée », Richard Stallman et la révolution du logiciel libre, paraît chez Eyrolles. Quel message faut-il y voir ?

Richard Stallman : Il s’agit de ma biographie, pas d’un livre d’opinions. J’ai corrigé et modifié partiellement celle qu’avait écrite Sam Williams [journaliste américain, NDLR], en préservant ses citations et beaucoup de ses impressions. Plus de 20 % viennent de moi. Mais on y trouve aussi les idées du mouvement pour le logiciel libre.

Il existe quatre libertés essentielles auxquelles l’utilisateur d’un programme a droit [voir encadré ci-dessous, NDLR]. Avec elles, ce dernier a le contrôle du programme et donc celui de l’informatique. Si un programme ne respecte pas ces quatre points, il impose un pouvoir injuste aux utilisateurs. Nous l’appelons « privateur » parce qu’il les prive de cette liberté. Je suis contre ce genre de logiciel ! Notre but est donc de libérer les utilisateurs en remplaçant tous les programmes « privateurs » par du libre ou en les rendant libres. Un programme libre est le seul chemin conduisant à la liberté.

01.net : Selon vous, quelles sont les forces et les faiblesses du logiciel libre ?

Richard Stallman : Notre force est d’avoir développé des systèmes d’exploitation et des applications libres pour presque toutes les activités informatiques ordinaires. Notre faiblesse est que la plupart de leurs utilisateurs n’ont pas conscience de l’idée même de la liberté pour laquelle nous nous battons.

Ils connaissent notre logiciel libre sous l’expression « open source », terme qui a été conçu pour ne pas suggérer l’idée de liberté. De la même façon, ils pensent que notre système GNU [signifiant GNU is not Unix, NDLR] s’appelait Linux et a été développé par Linus Torvalds, qui n’est pas pour cette liberté.

01.net : Le « libre » va-t-il devenir une alternative aux grands éditeurs qui préservent jalousement leur code ?

Richard Stallman : Je ne connais pas l’avenir. Il dépend de vous tous. Si tu exiges la liberté et si tu luttes pour elle, nous pouvons construire ensemble un futur libre. Si tu penses commodité à court terme, tu seras victime de la colonisation numérique.

«La loi Hadopi nuit à l’égalité»

01.net : Vous avez sûrement suivi de près la « saga » Hadopi. Quel est votre avis sur le sujet ?

Richard Stallman : La Hadopi interdit la fraternité en attaquant la liberté. Elle nuit aussi à l’égalité, parce qu’une poignée d’organisations auront le pouvoir de dénoncer quelqu’un selon cette loi. Elle reflète donc la haine de Nicolas Sarkozy envers les droits de l’homme. Il a choisi de servir les entreprises du divertissement dans leur guerre globale contre la fraternité.

01.net : Quel peut être le modèle pour financer les artistes aujourd’hui ?

Richard Stallman : Le système actuel, fondé sur le droit d’auteur, ne rétribue pas de façon équitable la plupart des artistes, seulement les stars. Il finance aussi très bien les grandes entreprises. Cela ne justifie pas d’interdire aux gens de coopérer entre eux. Il faut donc remplacer le système.

J’ai proposé deux options. L’une est fondée sur un système de paiements volontaires. Les amateurs d’art aiment financer les artistes, mais avec les moyens actuels c’est peu commode. Je propose donc que chaque individu qui reproduit une œuvre ait un bouton sur lequel il pourra appuyer afin d’envoyer à ses créateurs 1 euro (ou une somme correspondant au pays).L’autre solution serait un impôt à diviser entre les artistes, et uniquement les artistes, en fonction de leur succès, mais pas de façon linéaire. Je propose que l’argent perçu par chaque artiste augmente moins vite que son succès, l’inverse d’un impôt progressif. Ainsi, chaque star reçoit plus que les autres, mais pas dans les proportions du système actuel. Il pourrait donc financer plus d’artistes que le système qui prévaut en ce moment, avec moins d’argent.

Francis Muguet [un chercheur français, NDLR] a proposé un système qui reprend ce genre d’idées et qui fonctionne selon les relations juridiques actuelles. C’est le mécénat global (mecenat-global.org).

(1) Richard Stallman et la révolution du logiciel libre : Une biographie autorisée, de Richard Stallman, Sam Williams, Christophe Masutti. Editions Eyrolles.

Richard Stallman a beaucoup de détracteur dans la sphère libérale, il est souvent accusé de hippie utopiste. Le modèle qu’il propose est complètement à l’opposé de l’individualisme des théories de notre actuel gouvernement. Malgré les notions de partage et de communauté un peu sortie des slogans de mai 68, l’utopie du « logiciel libre » de Richard Stallman a prouvé son efficacité par l’existence d’un nombre chaque jour grandissant d’utilisateur de logiciel libre. L’engouement pour les systèmes d’exploitations GNU/Linux en est la preuve indiscutable. Il faut savoir aussi que 90% des logiciels nécessaire au bon fonctionnement d’internet (serveur) sont issus du développement de la communauté du logiciel libre.

La liberté que nous connaissons aujourd’hui sur le net est en grande partie dû à ce mouvement initié dans les années 1980. Et cette liberté est aujourd’hui menacée en France par les lois Hadopi et Loppsi. C’est en prenant conscience de ce fait qu’on pourra préserver cette liberté.

La Biographie autorisée de Richard Stallman est disponible à la vente chez Eyrolles à cette page pour seulement 22€. Et en libre téléchargement sur framabook :

Richard Stallman et la révolution du logiciel libre

Mithrandir79

Les commentaires sont désactivés pour ce billetRecevoir l’IP d’un PC distant par mail

Voici un modeste tuto pour créer un script d’envoi d’email automatique afin de connaître l’adresse IP d’un PC distant. Cela permet d’utiliser par exemple VNC pour accéder au PC de sa maison sans avoir de dyndns. Ce tuto est destiné au utilisateur de Debian ou Ubuntu. Sinon passez en mode root lorsque « sudo » est indiquer dans les commandes.

1- Installation Postfix, curl et sendmail :

Postfix est un serveur SMTP sa fonction est d’envoyer le mail sur le net.

sudo apt-get install postfix procmail sasl2-bin

La configuration de postfix :

Ok>Site Internet>Ok>Ok> »nom du serveur mail par défaut le nom du PC »>Ok

Rem: Postfix sera désinstallé lors de l’installation de sendmail, c’est une petite bidouille pour configurer plus rapidement le compte mail root.

Curl permet d’afficher dans un terminal le code source d’une page internet. Et Sendmail permet d’envoyer des emails à partir d’un terminal.

Ensuite on créer un lien entre la commande mail du script avec l’exécution de Sendmail.

sudo apt-get install sendmail curl

sudo ln -s /usr/sbin/sendmail /bin/mail

2- Script « autoIP.sh » :

Nano est un éditeur de texte qui fonctionne dans un terminal. (Il est beaucoup plus simple d’utilisation que Vim.)

nano autoIP.sh

Copier coller le script ci-dessous en modifiant l’adresse mail de destination. Ou recopier le à la main.

#! /bin/sh

curl http://www.mon-ip.com/ \

| grep -Eo '[0-9]{1,3}(\.[0-9]{1,3}){3}' \

| mail xxxxxxxxxxxx@wanadoo.fr

Pour sortir et sauvegarder un fichier dans nano « Ctrl+x » et répondre « O » (2x)

REM: explication du script

- « #! /bin/sh » Permet de savoir quel est la nature du code a exécuter et de le lancer avec le programme approprié.

- « curl http://www.mon-ip.com » curl va chercher le code source de la page internet qui contient votre adresse IP dynamique que votre FAI vous a attribué pour 24h.

- « \ » l’antislash permet d’écrire une commande sur plusieurs ligne rendant plus lisible le code au programmeur.

- « | » le pipe (qui se dit « paillepe ») permet de transférer le résultat de sortie d’une commande vers l’entrée d’une autre commande. Ici Curl envoie le code source à grep pour qu’il puisse l’analyser.

- « grep » est un programme de tri qui permet d’isoler certaines itérations

- « [0-9]{1,3}(\.[0-9]{1,3}){3} » définie le masque des données recherchées. Littéralement « [0-9] » comporte des chiffres de 0 à 9 « {1,3} » contient de 1 à 3 chiffres. La suite est identique sauf qu’on ajoute un séparateur « . » qu’on multiplie par 3. Cela donne un masque IP suivant XXX.XXX.XXX.XXX où X est un chiffre entre 0 et 9.

- « mail xxxxxxxxxx@wanadoo.fr » envoie le résultat obtenu par grep à une adresse mail definie.

3- Rendre executable le script :

Sur linux pour qu’un script puisse être exécuter il doit avoir les droits d’exécutions.

sudo chmod +x ./autoIP.sh

4- Configurer cron (/!\ pour utilisateur expérimenté) :

Cron permet de programmer le déclenchement de logiciel périodiquement ou ponctuellement de façon automatique.

sudo nano /etc/crontab

Ajouter vos programmations à la suite des lignes déjà existante. En sachant que les données sont à écrire dans cette ordre « minute heure jours mois jour_de_la semaine utilisateur commande » le tout à chaque fois séparer par un espace et une astérisque quand l’option n’est pas utilisée.

Exemple de programmation pour une exécution 4 fois par jours tous les jours (00h00 6h00 12h00 18h00)

0 0 * * * root /home/user/autoIP.sh

0 6 * * * root /home/user/autoIP.sh

0 12 * * * root /home/user/autoIP.sh

0 18 * * * root /home/user/autoIP.sh

Pour quitter et sauvegarder dans nano « Ctrl+x » et « o »

Pour plus de précision visiter cette page (elle n’est pas toute récente mais elle a le mérite d’être en français et simple à comprendre).

5- Installer et configurer gnome-schedule version GUI de cron (pour utilisateur utilisant gnome):

sudo apt-get install gnome-schedule

Ajouter dans le menu un raccourci en mode root

gksu /usr/bin/gnome-schedule

Programmer dans gnome-schedule l’exécution du script à interval régulier (toutes les 6 heures c’est un bon compromis). Commande à utiliser pour lancer le script :

sh /home/user/autoIP.sh

Attention pour les tâches planifié ne nécessitant pas des droits administrateur, exécuter gnome-schedule sans « gksu ».

Mithrandir79

Les commentaires sont désactivés pour ce billetHadopi: 7 Observations de Daniel Vangarde

En parcourant les commentaires de cette article je suis tombé sur ce texte montrant le projet de loi Hadopi sous l’oeil critique d’un artiste. Daniel Vangarde nous donne son point de vu sur la loi Hadopi dont la haute autorité devrait entrée en action à la fin du printemps (si les décret d’application son publié à temps). Je pense que son avis est très éclairé et justifié, beaucoup d’autres artistes devraient s’en inspirer au lieu de se rallier au pro-hadopi.

Voici son commentaire dans son intégralité:

« 7 OBSERVATIONS A PROPOS DU PROJET DE LOI H.A.D.O.P.I.

Par Daniel Vangarde, auteur-compositeur, éditeur et producteur de chansons.

Le projet de loi H.A.D.O.P.I. appelle de ma part (après quinze ans de recherches sur l’histoire contemporaine du droit d’auteur et de la propriété intellectuelle) les 7 observations suivantes:

1. Alors que ce projet de loi est censé protéger le droit d’auteur, l’intitulé « Haute Autorité pour la Diffusion des Oeuvres et la Protection des Droits sur Internet » ne fait aucune référence à l’auteur.

2. La diffusion des oeuvres est l’affaire des auteurs et des partenaires qu’ils choisissent. Ce n’est pas l’affaire d’une autorité administrative. En matière de droit d’auteur, il n’existe qu’une autorité, celle de l’auteur. L’autorité de l’auteur s’exerce à travers son droit (le droit d’auteur) de décider librement des conditions d’exploitation de son oeuvre, notamment la manière dont il souhaite la diffuser. Une « haute » autorité administrative qui se substituerait à l’autorité de l’auteur serait la négation même du droit d’auteur et de la propriété intellectuelle.

3. L’accaparement de l’autorité de l’auteur par une « haute » autorité qui s’autoriserait, sous le prétexte de la protection de la propriété intellectuelle et du contrôle de l’utilisation qui est faite de la musique, à surveiller et espionner la population* au mépris des libertés individuelles fondamentales, ne serait pas une première: un tel procédé fut instauré, mis en place et utilisé en Allemagne puis en France (agents assermentés de la Reichsmusikkammer/Kontrollabteilung et du C.P.A.D.C.E.M….) aux heures les plus sombres de notre histoire contemporaine.

4. Si les sociétés d’auteurs sont déterminées en 2009 à préserver coûte que coûte un système de contrôle et de gestion des droits d’auteur mis au point entre 1933 et 1944, c’est qu’il est impossible de passer d’un système à un autre sans faire l’audit du système que l’on va quitter.

5. Les sociétés d’auteurs unies derrière le projet de loi H.A.D.O.P.I., qui est soumis à la représentation nationale, se présentent comme les protecteurs des droits d’auteur générés par l’utilisation des oeuvres sur Internet. Or, ces sociétés (SACEM, SACD,SCAM, SDRM) ont signé le 13 mai 1996 un « Avenant au protocole d’accord général organismes nationaux de radio-télévision / sociétés d’auteurs du 11 juillet 1983 en ce qui concerne FRANCE 2″ par lequel elles ont concédé à la télévision nationale le droit d’utiliser le répertoire qu’elles représentent pour « la diffusion de messages de toute nature (sic) par télématique et, notamment, via INTERNET », sans contrepartie financière. Ces sociétés d’auteurs ont en fait concédé à la télévision nationale française, sans autorisation préalable des auteurs ni contrepartie financière, le droit de diffuser sur Internet les oeuvres du monde entier, qu’elles représentent en France**.

6. L’économie des échanges de propriété intellectuelle à l’heure de la dématérialisation des supports et de la divulgation e-numérique de la création artistique, littéraire et scientifique doit être définie et construite en tenant compte des intérêts, des droits et des devoirs de chacun. Elle doit tenir compte également des évolutions de la société et des avancées technologiques, qui doivent être considérées comme des opportunités nouvelles et non comme des ennemies de la création. C’est un enjeu fondamental de ce début du XXIè siècle.

7. L’arsenal coûteux des technologies de surveillance d’Internet et de ses utilisateurs prévu par le projet « riposte graduée » de la loi H.A.D.O.P.I. (en langage militaire, la riposte graduée vise à éviter l’usage prématuré de la bombe atomique) ne saurait régler la question du téléchargement des fichiers musicaux et audio/visuels. Mais il pourrait être d’une sinistre efficacité en ce qui concerne la surveillance d’Internet et de ses utilisateurs.

* Contrôle et filtrage des réseaux, installation de mouchards électroniques au coeur des terminaux personnels permettant de connaître, contrôler et éventuellement sanctionner le comportement des utilisateurs, etc.

* * Les signataires de cet avenant sont Jean-Pierre ELKABBACH / FRANCE 2, Jean-Loup TOURNIER / S.A.C.E.M., Olivier CARMET (avocat de la S.A.C.E.M. jusqu’en février 1996) / S.A.C.D., Laurent DUVILLIER / S.C.A.M. et Jean-Loup TOURNIER / S.D.R.M.. »

Mithrandir79

Les commentaires sont désactivés pour ce billet